今年1月,小红书开通了风险地点的举报专线,至今据此增添了各类风险地点共229个。平台已标记过的风险地点总数超一千。小红书副总裁许磊说,除风险打卡地专项小组外,小红书平台治理团队还有专项小组或队列十余个,平台要充当好“把关人”的角色。

全文5245字,阅读约需10分钟

比干的工作电脑里有张共享表格,每天,上万条信息在其中流转。信息都与国内外的风景地标相关,有徒步路线、登山攻略、露营指南等等——都来自小红书上的用户笔记。

作为小红书平台治理团队的一员,比干负责“风险目的地挖掘”,为平台用户定义哪些地点是有人身风险的、不宜轻易前往“打卡”。

经用户举报、团队自主巡查,风险地点的线索被更新入表格,由比干查证。“第一步,全网搜索,这个地点有没有官方或企业在管理;第二步,去文旅局检索地点信息,看它是否被开发;最后一步,综合资料和过往报道,看该地点过去是否发生过游客伤亡事件。”一旦确认某地有风险,比干会召回笔记,转交下一环节的同事二次审核,再做最终处理:或限流,或置顶安全提醒的笔记,或贴上风险提示条。

比干说,每年六月以后,水库、湖泊、溪流等涉水笔记大量出现,团队的工作重心也转向于此,“涉水地点分几种,有的是有人管理的,比如水库、海滩。还有的是无人看管的小河沟、小溪流,但是也没有明确禁止进入的标牌。还有一种是雨水蓄积出来的大水坑,许多用户也会到那里打卡,当做一个玩水的地点。”而后两者往往伴随危险。

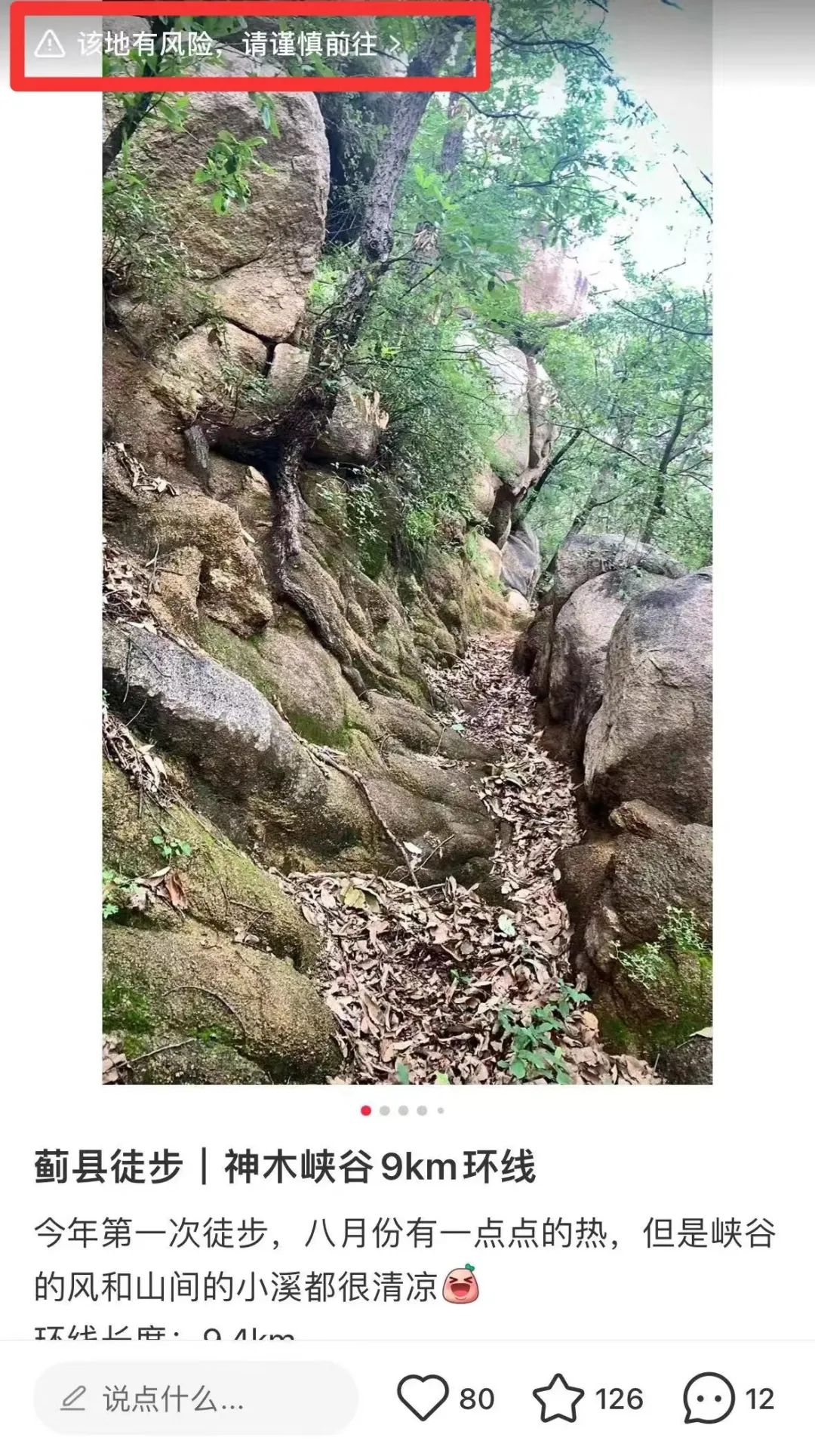

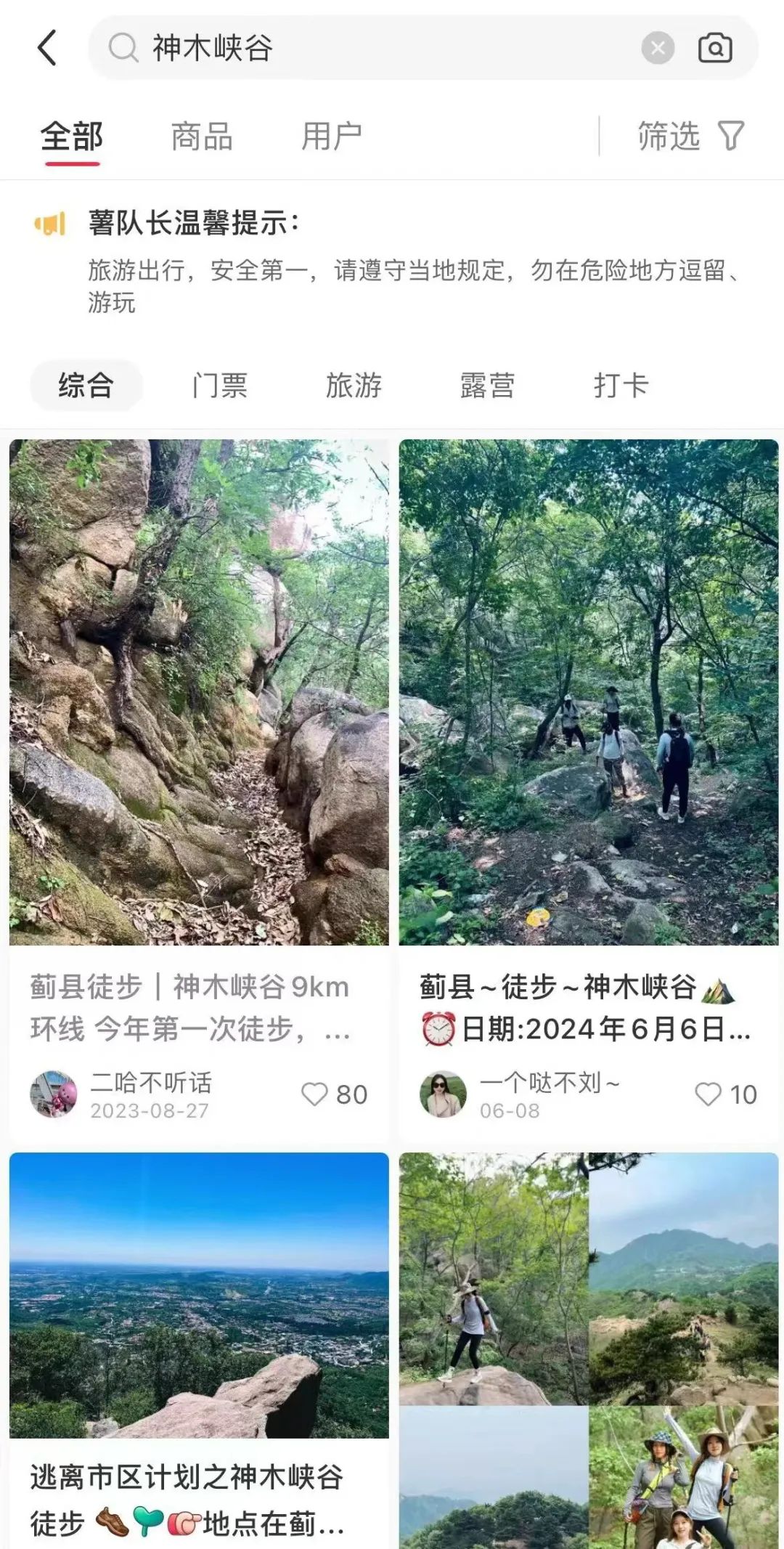

她举例,不久前,团队发现天津蓟县有一个叫神木峡谷的地方,大量出现在近期的用户笔记中。经她核实,神木峡谷是未开发的野景区,内有山间溪流。团队将此地定义为“风险目的地”,在相关笔记上做了贴条提醒,“该地有风险,请谨慎前往”。

团队还收到用户举报,称山东济南狼猫山水库出现打卡笔记,“经查,那个水库安全性上是有纰漏的。”比干与同事随即将相关笔记打上了“旅游出行,安全第一”的贴条。

仅在今年六月,比干所在的风险打卡地专项小组已新增涉水风险打卡地超过70个。今年1月,小红书开通了风险地点的举报专线,至今据此增添了各类风险地点共229个。平台已标记过的风险地点总数超一千。

比干把自己的工作总结为“发现问题,定义问题,解决问题”。她说,自己只是团队的近四千分之一。

除风险打卡地专项小组外,小红书平台治理团队还有专项小组或队列十余个,涉及未成年人保护、虚假种草、诈骗等多个方面,整个团队有成员近四千人。“接近平台全部员工的一半。”小红书副总裁许磊说。

许磊表示,在信息爆炸的时代,平台要充当“把关人”的角色,就要做好内容的治理工作。但内容治理并不是简单的、流水线式的审查,相反,日常的治理工作有许多可商榷之处——比方说,哪些内容需要治理?除了法律与道德之外,治理是否还有别的标准?

那么,究竟什么是合理的平台治理?它的痛点、难点和边界分别是什么?就以上问题,我们对话了小红书副总裁许磊。

━━━━━

把关人

新京报:现在的平台治理,与以往有何不同?

许磊:平台治理随着互联网的发展逐渐演变为一个重要行业。早期的互联网平台以PGC(专业生产内容)为主,内容生产者是比较固定的,比如门户网站。2000年左右,网络上出现了一些小型的论坛。这些论坛内容比较垂直,代表着最初的UGC(用户生成内容)形态。但由于这些论坛体量相对较小,内容通常比较固定,版主就可以完成审核工作。

随后进入搜索引擎时代,搜索引擎集成了海量的动态信息,如果有用户报告内容侵权,平台删除该内容,就算尽到责任。但到了web2.0时代,UGC增加,互联网用户从以论坛为代表的兴趣垂类社区,逐渐转移和汇聚到微博、抖音、快手、小红书这些用户量过亿的平台上。平台治理就变得更加复杂了,因为用户可以发表任何内容。所以在UGC时代,治理很大程度上是事后把关,由平台来担任“把关人”的角色。2016年,国家出台了网络安全法,逐渐规范了平台的主体责任。

新京报:在今天,平台治理具体如何进行?

许磊:现在各大平台的内容审核逻辑比较相似,基本都是先过机审模型,甄别风险。确定有问题的,机器就直接处置,不让内容发出来。如果机器筛选出可疑内容,不确定能不能发,就交由人工审核。

我们对于高曝光的,也就是通俗说的“爆款”内容,还有两道人工审核。也就是当内容曝光量到了一定的阈值,一定会进行人工审核。到这个审核环节,工作人员的综合素质会更高,对信息的甄别能力会更强。

早期,我们不区分队列,多类内容一起审。后来摸索出要术业有专攻,就分出了反诈、危险地打卡等等十余个队列,让团队成员集中发展审核某一队列的能力。我们还在不断地新增队列,像2021年年底,新增了医美的队列,2022年,新增了未成年人的队列。

新京报:什么样的情况下,会考虑新增队列?

许磊:我们会长期观察危险信号,内部叫做风险的挖掘和预警。

首先是要依靠站内举报,当针对同一问题的大量举报出现,往往就是重要的信号。其次我们也会关注是否有异常的内容波动——比方说,低俗化的内容,不一定会被用户举报,但是突然同时大量出现,我们就会加重审核,看是否在引流或导向上有问题。

我们还会依据站外的反馈,比如媒体报道。有时候媒体报道不只是针对小红书,而是对整个行业进行监督。那么如果有别的平台的问题被报道出来,我们也会参考自查。

2021年,平台开始大量出现医美相关的笔记,我们观察发现,这个行业有很多灰色空间。那一年也出现了不少医美乱象的媒体报道。我们综合研判下来,就新增了医美的风险队列。

我们有专门的研判团队,负责收集信息,定期研判有哪些新的风险信号,应采取什么样的对策,是否要成立专项,等等。

新京报:哪些内容审核需要设立专项?有过哪些专项?

许磊:通常我们立一个专项的时候,都是因为这个问题本身需要被定义得更清晰。反诈就是最典型的,有些诈骗只靠机器就能识别拦截,还有些复杂的杀猪盘,只看单篇笔记内容,并不会显得多么异常。我们就要观察用户的所有过往笔记,研究他是怎么立人设、养人设,分析他是否有频繁给其他用户发评论或私信的行为,再判断是不是诈骗。而且诈骗形式每隔一段时间就会更新,也需要我们不断跟进研究。这种时候就会成立专项,长期跟进。

有些专项是长期存在的,比如未成年人专项,直到今天还在。它逐渐泛化成一个大类问题,过往的经验可以利用,又不断有新的问题和挑战出现。未成年人的消费、社交、出行等等一系列方向,都需要我们长期关注。

新京报:一旦锁定违规内容,平台的处理方式有哪些?

许磊:最轻的处理方式是限流,限流之外就是拦截,即删评论、删笔记,甚至封号。最重的方式是封设备,同一台手机或者平板,不能再使用小红书,即使换手机号也不行。

━━━━━

从依靠外部信号到主动发掘

新京报:总的来说,平台治理的难点是什么?

许磊:治理维度可以分为三个层次,动机、行为和结果。结果是最好识别的,比方说诈骗行为已经产生了,被骗用户举报、投诉或者是报案了,平台再找寻源头进行治理,就比较容易。动机是最难判定的,我们没法识别一个用户内心到底在想什么。

平台治理的重心其实是在行为层,我们的工作主要是通过更前置地识别、干预“行为”,避免“结果”的发生。当信息量足够大,我们就可以更确定地定性某种“行为”。最难的就是那类短文字,有的评论区里,甚至只有一个字,“私”。“私”字可以代表很多含义,用户发送这个字,到底是表达要私下达成交易,还是觉得在公开的评论区讲话不方便,想转去私信沟通?正如《信息论》里讲到的,信息量越大,不确定性越小。信息量越小,不确定性越大。

在视频、图片、文本等内容类型中,其实最难审的是评论这种“短文本”,这个时候,就要结合用户的其他笔记、其他交互场景来判断,用户评论行为可能代表着什么。

新京报:你刚才提到,在一些违规行为中,用户的发言是有“变体”的,你们如何识别“变体”?

许磊:前段时间,打拐志愿者发文称小红书上有非法送养、领养孩子的信息,参与的用户还会有自己的“暗语”。那首先,我们会在站内收集这类可疑的笔记和评论,分析共性。同时也会关注站外舆情,不管是网上的争议还是媒体的报道,看是否有可用信息。我们会把所有收集到的信息,整理、归纳、总结,把一些经常出现在疑似非法送养、领养内容中的用词,放入我们自己的词库。我们不断升级完善词库、模型,“黑产”也在不断调整他们的违规内容变体,试图逃避审核。这是一个长期的对抗过程,我们会尽全力对违规内容进行识别和拦截。但这只能是一个后置的工作,因为我们无法预判有哪些变体会出现。

这中间也会出现难以辨别的时刻。“领养”在小红书平台是一个高频出现的词汇,许多人想领养宠物,也是发笔记或者评论说“求领养”,并且会把宠物也称为“孩子”或者“毛孩子”。如果机器无法准确识别,就需要我们人工去处理。

新京报:对于模糊的、难界定的内容,你们治理团队是如何应对的?

许磊:看事情的严重程度,像违法送养、领养孩子,这在法律和道德层面都是很严重的问题,平台也绝不姑息。我们不仅要处理明确的违法内容,部分只是发帖称自己想收养孩子的账号,我们也封号了。可能在客观上,我们只看到了用户的动机,持续在平台上表达自己想要一个孩子的诉求,不意味着一定会导向非法送养和领养。但是只要我们分析认为,他的动机很强,我们就会用最严格的方式,去降低导向违法结果的可能性。

在这样的背景下,我们在这个专项中第一批处置了237篇笔记和1914条违规评论。也把违规并有嫌疑的账号第一时间提交给了相关部门。

此外,我们也有发布站内公告,告诫大家非法领养和送养是不可取的,收养孩子需要走规范的法律程序。我们希望通过与用户沟通,可以把违法的可能性,从动机层面就消除掉。

新京报:平台治理通常需要依赖用户或外部反馈?

许磊:外部反馈一定是重要的,举一个特别典型的例子:去年下半年,有个用户在平台发笔记,说出门旅游最便宜实惠的过夜方式,就是找个医院,谎称自己有疾病,出几十块钱挂号费,然后让医生观察,在医院的急诊室睡一晚。

这样的行为,违反公共秩序,也占用公共医疗资源,是平台反对的。但这又是一个非常个体的行为,整个平台上,就该用户发了这样一篇笔记。一直到这篇笔记被转到别的平台,上了热搜,我们团队才发现有这么一篇笔记。

但同时,平台主动判别的比例也在上升。治理团队成立早期,我们是根据舆情做处置,现在,我们日常工作里的一大半,都用来主动探测、监测站内信息,而不是单纯依靠外部信号了。随着治理经验的丰富,我们也会不时预判一些风险点。比方说,最近到了暑假,我们就知道季节性针对未成年人、学生的风险判别又要加强了。最近我们就观察到,平台多出了许多有偿兼职的笔记,真假难辨,可能涉及诈骗,需要抽出人力,留心治理。

━━━━━

用《社区公约》传递平台的内容价值观

新京报:平台治理的边界在哪里?如何平衡治理的需求与用户的言论自由?

许磊:很多时候,平台当然无法忽略或者代替用户的决定权。比方说危险地打卡,像虎跳峡,高手去走去攀,完全没问题,但是对新手来说就风险太大。针对类似的内容分享,我们就以风险提示条为主,给出尽量多的信息,让用户自己决定,要不要去走这个路线。

平台治理的一个原则是,不能不让别人分享内容,而且要鼓励那些真诚的分享。比如有些用户觉得某个涉水景区,夏天适合避暑,但他不一定知道该地遇汛期会很危险。他发出了相关的种草内容,平台就要帮助他进一步判别风险,并做好提示。

另一个原则是保护创作者的感受,抵制引战的、冒犯的、不友善的评论或笔记,包括炫富的内容在内,会被限流处理。

新京报:治理团队内部有规章制度可依循吗?

许磊:有,我们内部叫做《社区公约》。是我们治理团队和内容运营团队,集体讨论、制定出来的。随着新风险、新问题的产生,《社区公约》也会修订或更新,向所有用户公布。平台的《社区公约》,往往比法律和公序良俗都要更严格一些。

新京报:在未来,平台治理会如何发展?

许磊:在可预见的五年、十年,整个行业的平台治理模式应该都不会有大的变化,依然是人机结合。但是无论人或机,都会不断提升效率,达成更高效的合作。

我相信内容审核是永远需要有人来参与的,人可以做机器无法做的复杂判定。随着平台上内容数量的不断增多,治理团队也会不断扩容。未来的治理人员会更专业、更细分,比如要治理医疗领域的内容,我们就会招聘有医学背景的团队成员。小红书治理团队也会持续扩容,加大投入。在平台治理上我们大的原则还是希望守土有责,对于一些高危的风险还是希望绝不姑息,这也是平台价值观。

文/冯雨昕 编辑 胡杰 校对 张彦君